- +1

Light | 深度學(xué)習(xí)賦能下的光學(xué)計量

撰稿 | 左 超 錢佳銘

2016年3月,谷歌旗下人工智能(AI)公司DeepMind憑借其開發(fā)的AlphaGo人工智能系統(tǒng)以總比分4:1戰(zhàn)勝圍棋世界冠軍李世石,引發(fā)了全人類對新一輪人工智能浪潮——深度學(xué)習(xí)技術(shù)的廣泛關(guān)注和持續(xù)熱議。從那刻起,人們見證了深度學(xué)習(xí)技術(shù)的快速崛起和廣泛應(yīng)用——它以前所未有的性能解決了計算機(jī)視覺、計算成像和計算機(jī)輔助診斷等領(lǐng)域的諸多難題與挑戰(zhàn)。與此同時,Google、Facebook、微軟、蘋果和亞馬遜這五大科技巨頭無一例外投入越來越多資源搶占人工智能市場,甚至整體轉(zhuǎn)型為人工智能驅(qū)動的公司。它們開始“點燃”數(shù)據(jù)挖掘的“藝術(shù)”,并開發(fā)出易于使用的開源深度學(xué)習(xí)框架。這些深度學(xué)習(xí)框架使我們能夠使用預(yù)先構(gòu)建和優(yōu)化的組件集合,以更清晰、簡明和用戶友好的方式構(gòu)建復(fù)雜、大規(guī)模的深度學(xué)習(xí)模型,而無需深入了解底層算法的細(xì)節(jié)。國內(nèi)“BAT”也將深度學(xué)習(xí)技術(shù)作為重點戰(zhàn)略方向,憑借自身優(yōu)勢積極布局人工智能領(lǐng)域。深度學(xué)習(xí)已經(jīng)迅速地離開了學(xué)術(shù)界的殿堂并開始重塑工業(yè)界。

另一方面,光學(xué)計量學(xué)(Optical Metrology)是一類以光信號為標(biāo)準(zhǔn)/信息載體的測量科學(xué)和技術(shù)。它是一門古老的學(xué)科,因為物理學(xué)的發(fā)展從一開始就由光學(xué)計量技術(shù)所驅(qū)動的。但反過來,光學(xué)計量學(xué)也因激光、電荷耦合器件(CCD)和計算機(jī)的發(fā)明而發(fā)產(chǎn)生了重大變革。現(xiàn)如今已發(fā)展成為一個涵蓋廣泛的跨學(xué)科領(lǐng)域,并與光測力學(xué)、光學(xué)工程、計算機(jī)視覺和計算成像等學(xué)科緊密相關(guān)。鑒于深度學(xué)習(xí)在這些相關(guān)領(lǐng)域所取得的巨大成功,光學(xué)計量學(xué)的研究人員也無法抑制他們的好奇心,也開始積極投身到這一快速發(fā)展的新興領(lǐng)域中。不同于傳統(tǒng)的基于“物理先驗”方法,基于“數(shù)據(jù)驅(qū)動”的深度學(xué)習(xí)技術(shù)為解決光學(xué)計量領(lǐng)域的諸多挑戰(zhàn)性問題提供了新的可能,并展現(xiàn)出了巨大的應(yīng)用潛力。

在此背景下,2022年3月,南京理工大學(xué)與新加坡南洋理工大學(xué)的研究團(tuán)隊在國際頂級光學(xué)期刊《Light: Science & Applications》上聯(lián)合發(fā)表了題為"Deep learning in optical metrology: a review"的綜述文章,文章第一作者為南京理工大學(xué)左超教授,南京理工大學(xué)博士研究生錢佳銘為共同第一作者,南京理工大學(xué)左超、陳錢教授、新加坡南洋理工大學(xué)錢克矛教授為論文的共同通訊作者,南京理工大學(xué)為論文的第一單位。

文章系統(tǒng)總結(jié)了光學(xué)計量學(xué)中經(jīng)典技術(shù)與圖像處理算法,簡述了深度學(xué)習(xí)的發(fā)展歷史、網(wǎng)絡(luò)結(jié)構(gòu)及技術(shù)優(yōu)勢,并對其在各種光學(xué)計量任務(wù)中(如條紋去噪、相位解調(diào)和相位展開)的具體應(yīng)用進(jìn)行了全面綜述。通過對比深度學(xué)習(xí)方法與傳統(tǒng)圖像處理算法的原理與思想上的異同,展示了深度學(xué)習(xí)在解決各種光學(xué)計量任務(wù)中“問題重構(gòu)”和“實際性能”方面的獨特優(yōu)勢。最后文章指出了深度學(xué)習(xí)技術(shù)在光學(xué)計量領(lǐng)域所面臨的挑戰(zhàn),并展望了其未來潛在的發(fā)展方向。

傳統(tǒng)光學(xué)計量

圖像生成模型與圖像處理算法

光學(xué)計量技術(shù)將光的基本屬性(如振幅、相位、波長、方向、頻率、速度、偏振和相干性等)巧妙地用作被測物的信息載體,以實現(xiàn)對被測物的各種特征數(shù)據(jù)(如距離、位移、尺寸、形貌、粗糙度、應(yīng)變和應(yīng)力等)的獲取1。光學(xué)計量因其非接觸、高速、高靈敏度、高分辨率、高精度等優(yōu)勢,在CAD /CAE、逆向工程、在線檢測、質(zhì)量控制、醫(yī)療診斷、文物保護(hù)、人機(jī)交互等領(lǐng)域得到了日益廣泛的應(yīng)用。在光學(xué)計量技術(shù)中,最常見信息載體為“條紋”與“散斑”。如大多數(shù)干涉測量法(經(jīng)典干涉、光彈、數(shù)字散斑、數(shù)字全息等)所處理的圖像是由物光和參考光相干疊加而成的干涉條紋,被測物理量被調(diào)制于干涉條紋的相位信息中2??;此外,條紋圖案還可以非干涉的方式生成,如條紋投影輪廓術(shù)(FPP)直接投影結(jié)構(gòu)光條紋圖案至被測物表面以測量物體的三維面型?。而在數(shù)字圖像相關(guān)(DIC)中,所拍攝的圖像則是樣品表面形變前后的散斑圖案,從中可獲得被測物全場位移和形變分布?;將DIC與立體視覺或攝影測量相結(jié)合,基于多視散斑圖像還可獲取被測場景的深度信息?。圖1總結(jié)了這些技術(shù)的圖像生成過程及其對應(yīng)的數(shù)學(xué)模型。

圖1 傳統(tǒng)光學(xué)計量技術(shù)中的圖像生成過程及對應(yīng)的數(shù)學(xué)模型

傳統(tǒng)光學(xué)計量離不開圖像處理技術(shù),對條紋/散斑的圖像處理可以理解為由捕獲的原始強(qiáng)度圖像反演出所需的待測物理量的過程。通常情況下,該過程并非“一步到位”,而是由三個具有邏輯層次的圖像處理步驟所構(gòu)成——預(yù)處理、分析和后處理。每個步驟都包含一系列圖像處理算法,這些算法層層疊加,形成一個“流水線”結(jié)構(gòu)[圖2],其中每個算法對應(yīng)于一個“映射”運算,其將圖像/類似圖像的矩陣輸入轉(zhuǎn)化為相應(yīng)維度(或重采樣的)的輸出。

(1)預(yù)處理:圖像預(yù)處理通過抑制或最小化不必要的干擾信號(如噪聲、混疊、畸變等)來提高圖像質(zhì)量,光學(xué)計量中代表性的圖像預(yù)處理算法包括圖像去噪?、圖像增強(qiáng)1?、顏色通道分離11、圖像配準(zhǔn)與校正12等。

(2)分析:圖像分析是圖像處理算法的核心步驟,用于從輸入圖像中提取與待測物理量相關(guān)的重要信息載體。在相位測量技術(shù)中,圖像分析的主要任務(wù)是從條紋圖像中重建相位信息,其基本算法包括相位解調(diào)13與相位展開1?;對于立體匹配技術(shù),圖像分析是指確定散斑圖像(樣品表面形變前后的散斑圖案/多視散斑圖像)對應(yīng)點間的位移向量,一般包括子集匹配和亞像素優(yōu)化兩個步驟1?。

(3)后處理:圖像后處理的目的是進(jìn)一步優(yōu)化測量得到的相位數(shù)據(jù)或散斑位移場,并最終將它們轉(zhuǎn)化為待測物理量。光學(xué)計量中常見的后處理算法包括去噪1?、誤差補(bǔ)償1?、數(shù)字重聚焦1?、參量轉(zhuǎn)換1?等。圖3給出了光學(xué)計量圖像處理層次結(jié)構(gòu)的概貌以及不同層中分布的各種圖像處理算法。

圖2 光學(xué)計量的典型圖像處理過程(如條紋投影輪廓術(shù))可分為三個主要步驟:預(yù)處理(如去噪、圖像增強(qiáng))、分析(如相位解調(diào)、相位展開)和后處理(如相位—深度映射)

圖3 光學(xué)計量圖像處理層次結(jié)構(gòu)的概貌以及不同層中分布的各種圖像處理算法

深度學(xué)習(xí)技術(shù)

原理、發(fā)展與卷積神經(jīng)網(wǎng)絡(luò)

深度學(xué)習(xí)是機(jī)器學(xué)習(xí)領(lǐng)域的一個重要分支,它通過構(gòu)建模擬人腦信息處理神經(jīng)結(jié)構(gòu)的人工神經(jīng)網(wǎng)絡(luò)(ANN),使機(jī)器能夠從大量歷史數(shù)據(jù)中進(jìn)行自底向上的特征提取,從而實現(xiàn)對未來/未知樣本的智能決策。ANN起源于McCulloch和Pitts在1943年建立的生物神經(jīng)元的簡化數(shù)學(xué)模型2?[圖4a]。1958年,Rosenblatt等21受生物神經(jīng)元模型的啟發(fā)首次提出了可模擬人類感知能力的機(jī)器——單層感知機(jī)。如圖4b所示,單層感知機(jī)由單個神經(jīng)元構(gòu)成,神經(jīng)元以偏置(b)和權(quán)重(w)為參數(shù),通過非線性激活函數(shù)將輸入映射到輸出。感知器的提出激發(fā)了大量研究人員對ANN的興趣,對神經(jīng)網(wǎng)絡(luò)的發(fā)展具有里程碑式意義。然而,單層感知器只能處理線性分類問題的局限致使隨后神經(jīng)網(wǎng)絡(luò)的發(fā)展停滯了近20年。80 年代,反向傳播(BP)算法的提出使多層神經(jīng)網(wǎng)絡(luò)的高效訓(xùn)練成為了可能。其基于鏈?zhǔn)椒▌t不斷調(diào)節(jié)神經(jīng)元間的權(quán)值以減小多層網(wǎng)絡(luò)的輸出誤差,有效解決了非線性分類和學(xué)習(xí)的問題,引發(fā)了“淺層學(xué)習(xí)”的繁榮22。1989年,LeCun等23受哺乳動物視覺皮層結(jié)構(gòu)啟發(fā)提出了卷積神經(jīng)網(wǎng)絡(luò)(CNN)的思想,為現(xiàn)代計算機(jī)視覺與圖像處理奠定了深度學(xué)習(xí)的基礎(chǔ)。隨后隨著神經(jīng)網(wǎng)絡(luò)層數(shù)的增加,BP算法的梯度消失/爆炸問題日益凸顯,致使90年代中期ANN的發(fā)展又陷入了停滯。2006年,Hinton等2?提出了一種深度置信網(wǎng)絡(luò)(DBN)的訓(xùn)練方法來應(yīng)對梯度消失問題;同時伴隨著計算機(jī)硬件性能、GPU加速技術(shù)的發(fā)展以及大量標(biāo)記數(shù)據(jù)集的出現(xiàn),神經(jīng)網(wǎng)絡(luò)步入了第三次發(fā)展高潮,從“淺層學(xué)習(xí)”階段邁入了“深度學(xué)習(xí)”階段。2012年,基于CNN構(gòu)架的AlexNet于ImageNet圖像識別比賽中一舉奪魁,使得沉寂20余年的CNN成為深度學(xué)習(xí)的主流框架之一2?。與此同時,一些新的深度學(xué)習(xí)網(wǎng)絡(luò)架構(gòu)及訓(xùn)練方法(如ReLU2?和Dropout2?)被提出以進(jìn)一步解決梯度消失問題,促使了深度學(xué)習(xí)的爆炸式增長。2016 年,谷歌旗下AI公司DeepMind所開發(fā)的人工智能系統(tǒng)AlphaGo擊敗圍棋世界冠軍李世石,引發(fā)了全人類對深度學(xué)習(xí)技術(shù)的廣泛關(guān)注2?。圖4給出了人工神經(jīng)網(wǎng)絡(luò)和深度學(xué)習(xí)技術(shù)的發(fā)展歷程與典型神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)示意圖。

圖4 深度學(xué)習(xí)與人工神經(jīng)網(wǎng)絡(luò)的發(fā)展歷程及典型神經(jīng)網(wǎng)絡(luò)的結(jié)構(gòu)示意圖

圖5 用于圖像分類任務(wù)的典型CNN結(jié)構(gòu)

a) 典型的CNN包括輸入層、卷積層、全連接層和輸出層 b) 卷積運算 c) 池化操作

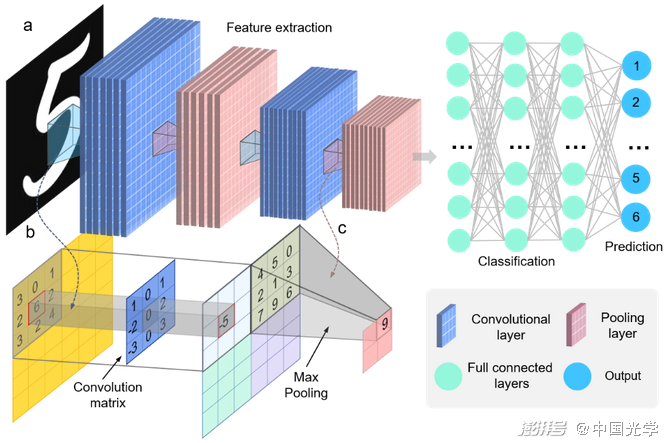

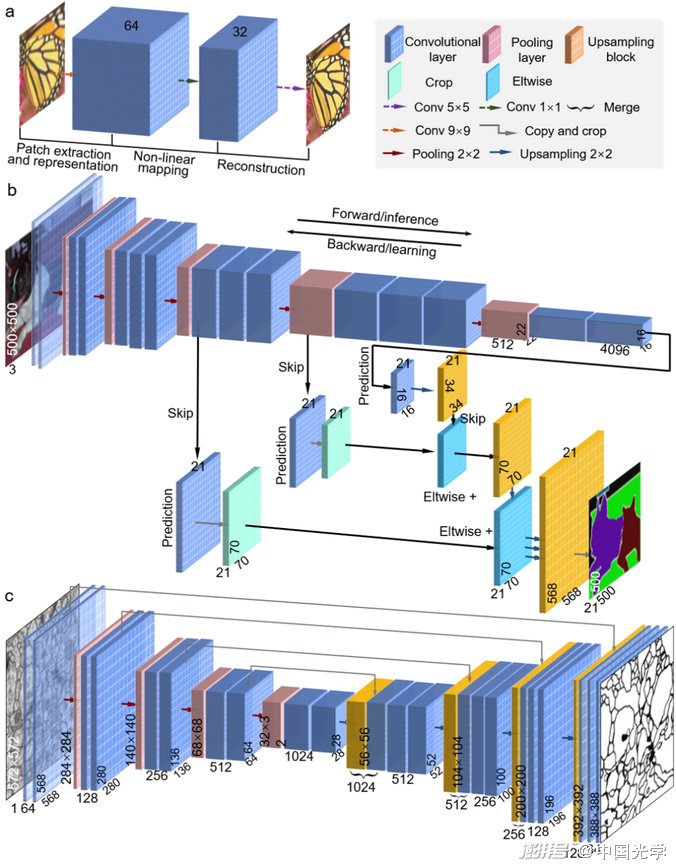

上述單層感知機(jī)是最簡單的ANN結(jié)構(gòu),僅由單個神經(jīng)元構(gòu)成[圖4b]。深度神經(jīng)網(wǎng)絡(luò)(DNN)由多層神經(jīng)元相互連接而成,相鄰層間的神經(jīng)元通常以全連接形式堆疊[圖4g]。在網(wǎng)絡(luò)訓(xùn)練期間,神經(jīng)元將相應(yīng)的輸入乘以一個權(quán)重系數(shù)并與偏置值相加,通過非線性激活函數(shù)輸出至下一層,同時網(wǎng)絡(luò)損失被計算并反向傳播以更新網(wǎng)絡(luò)參數(shù)。不同于常規(guī)的全連接層,CNN使用卷積層對輸入數(shù)據(jù)進(jìn)行特征提取2?[圖5a]。在每一層中,輸入圖像與一組卷積濾波器和添加的偏置進(jìn)行卷積以生成一個新的輸出圖像[圖5b]。CNN中的池化層利用圖像的局部相關(guān)性原理對圖像進(jìn)行子抽樣,在減少數(shù)據(jù)處理量的同時保留了有用信息[圖5c]。這些特征使得CNN廣泛應(yīng)用于計算機(jī)視覺的任務(wù)中,如目標(biāo)檢測3?和運動跟蹤31等。傳統(tǒng)的CNN構(gòu)架大多面向“分類”任務(wù),在輸出端舍棄了空間信息并產(chǎn)生了“向量”形式的輸出。然而,對于光學(xué)計量技術(shù)中的圖像處理任務(wù),神經(jīng)網(wǎng)絡(luò)必須能夠產(chǎn)生一個與輸入相同的(甚至更高)全分辨率輸出。為此應(yīng)該使用沒有全連接層的全卷積網(wǎng)絡(luò)結(jié)構(gòu),這樣的網(wǎng)絡(luò)構(gòu)架接受任意尺寸的輸入,用回歸損失進(jìn)行訓(xùn)練,并產(chǎn)生像素級的矩陣輸出。具有此類特征的網(wǎng)絡(luò)稱為“全卷積網(wǎng)絡(luò)結(jié)構(gòu)”的CNN,其網(wǎng)絡(luò)架構(gòu)主要包括以下三類:

(1)SRCNN:Dong等32跳過傳統(tǒng)CNN結(jié)構(gòu)中的池化層,采用幾個卷積層簡單堆疊的方式在輸出端保留了輸入維度[圖6a]。利用該思想構(gòu)建的SRCNN成為用于圖像超分辨任務(wù)的主流網(wǎng)絡(luò)框架之一。

(2)FCN:全卷積網(wǎng)絡(luò)(FCN)是由Long等提出的用于語義分割任務(wù)的網(wǎng)絡(luò)框架33。如圖6b所示,F(xiàn)CN使用傳統(tǒng)CNN[圖5]的卷積層作為網(wǎng)絡(luò)編碼模塊,將全連接層替換為反卷積層作為解碼模塊。反卷積層能夠?qū)ψ詈笠粋€卷積層的特征圖進(jìn)行上采樣使其恢復(fù)到與輸入圖像相同尺寸的輸出。此外,F(xiàn)CN通過跳級結(jié)構(gòu)將粗糙的高層特征與細(xì)致的低層特征相結(jié)合,使網(wǎng)絡(luò)在保留像素級輸出的同時更好地恢復(fù)了細(xì)節(jié)信息。

(3)U-Net:Ronneberger等對FCN作出改進(jìn)并提出U-Net網(wǎng)絡(luò)3?。如圖6c所示,U-Net的基本結(jié)構(gòu)包括一個壓縮路徑和一個擴(kuò)展路徑。壓縮路徑作為網(wǎng)絡(luò)的編碼器,使用四個卷積塊(每個卷積塊由三個卷積層和一個池化層構(gòu)成)對輸入圖像進(jìn)行降采樣并獲得壓縮特征表示;擴(kuò)展路徑作為網(wǎng)絡(luò)解碼器使用轉(zhuǎn)置卷積的上采樣方法來輸出與輸入相同尺寸的預(yù)測結(jié)果。U-Net采用跳躍連接對壓縮路徑和擴(kuò)展路徑進(jìn)行特征融合,使得網(wǎng)絡(luò)可以在淺層特征和深層特征中自由選擇,對語義分割任務(wù)來說更有優(yōu)勢。

上述全卷積網(wǎng)絡(luò)結(jié)構(gòu)的CNN能夠?qū)⑷我獯笮〉妮斎雸D像轉(zhuǎn)化為像素級的矩陣輸出,這與光學(xué)計量任務(wù)中圖像處理算法所對應(yīng)的“映射”運算的輸入輸出特征完全吻合,因此可以非常方便地對傳統(tǒng)圖像處理任務(wù)進(jìn)行“深度學(xué)習(xí)替換”,這為深度學(xué)習(xí)在光學(xué)計量領(lǐng)域的快速崛起奠定了基石。

圖6 三種能夠產(chǎn)生像素級圖像輸出的用于圖像處理任務(wù)的代表性全卷積網(wǎng)絡(luò)結(jié)構(gòu)的CNN

a) SRCNN b) FCN c) U-Net。

深度學(xué)習(xí)下的光學(xué)計量

思想與方法論的轉(zhuǎn)變

在光學(xué)計量技術(shù)中,原始條紋/散斑圖像與被測物理量間的映射可描述為從參數(shù)空間到圖像空間的正向物理模型和測量噪聲的組合,這可以解釋光學(xué)計量中幾乎所有原始圖像的生成過程。但從原始圖像中提取待測物理量是一個典型的“逆問題”。求解這樣的逆問題面臨著諸多挑戰(zhàn),如:未知或不精確的正向物理模型、誤差累積和局部最優(yōu)解以及逆問題的病態(tài)性等。在計算機(jī)視覺和計算成像領(lǐng)域,解決逆問題的經(jīng)典方法是通過引入被測物的先驗作為正則化手段限定解空間以使其良態(tài)化[圖7]。而在光學(xué)計量領(lǐng)域,解決逆問題的思路則與之大相徑庭。根本原因在于光學(xué)計量通常是在一個“高度可控”的環(huán)境中進(jìn)行的,因此更傾向于通過一系列“主動策略”,如照明調(diào)制、物體調(diào)控、多次曝光等來“主動調(diào)整”圖像的采集過程,這就可將原先的“病態(tài)逆問題”重塑為一個“良態(tài)且足夠穩(wěn)定的回歸問題”。例如由單幅條紋圖像解調(diào)絕對相位:由于正向物理模型中缺乏足夠的信息可以用來唯一穩(wěn)定地求解相應(yīng)的逆問題,該逆問題是病態(tài)的。而對于光學(xué)計量的研究者來說,解決該問題的方法非常簡單:我們可以進(jìn)行多次測量,通過獲取額外的多頻相移條紋圖像,絕對相位的獲取問題就演化為了一個良態(tài)的回歸問題。我們可以很容易地通過多步相移法13和時間相位展開法1?來從這些條紋圖像中恢復(fù)出被測物的絕對相位信息[圖8]。

圖7 在計算機(jī)視覺中(如圖像去模糊),由于從參數(shù)空間映射到圖像空間的正向物理模型不理想,所產(chǎn)生的逆問題是病態(tài)的。典型的解決方案是加入一些有助于正則化的先驗假設(shè)(平滑),將原始的病態(tài)問題重新表述為良態(tài)的優(yōu)化問題

圖8 光學(xué)計量通過主動控制圖像采集過程,將病態(tài)的逆問題轉(zhuǎn)化為良態(tài)的回歸問題。如在條紋投影輪廓術(shù)中,通過獲取不同頻率的額外相移條紋圖像,絕對相位可以很容易地通過多頻相移法和時間相位展開法來獲取

然而當(dāng)我們走出實驗室,進(jìn)入現(xiàn)實世界的復(fù)雜環(huán)境時,情況就可能會大相徑庭。上述主動策略往往對測量條件和被測對象施加了嚴(yán)格限制,例如:穩(wěn)定的測量系統(tǒng)、極小的環(huán)境干擾、靜止的剛性物體等。然而對于許多具有挑戰(zhàn)性的應(yīng)用而言,如惡劣的操作環(huán)境與快速運動的物體等,可能使上述主動策略成為一種“奢侈”甚至是不切實際的要求。在這種情況下,傳統(tǒng)的光學(xué)計量方法將面臨嚴(yán)重的物理和技術(shù)限制,如有限的數(shù)據(jù)量和正向模型的不確定性。如何從最少的(最好是單幀)條紋圖案中提取高精度的絕對(無歧義)相位信息,仍然是當(dāng)今光學(xué)計量學(xué)中最具挑戰(zhàn)性的問題之一。因此,我們期待著光學(xué)計量學(xué)原理和方法的創(chuàng)新和突破,這對其未來的發(fā)展具有重要意義。

深度學(xué)習(xí)作為近年來興起的一種“數(shù)據(jù)驅(qū)動”技術(shù),在光學(xué)計量領(lǐng)域受到越來越多的關(guān)注,并在近幾年取得了豐碩的成果。不同于傳統(tǒng)物理模型驅(qū)動的方法,深度學(xué)習(xí)方法通過人為創(chuàng)建一組由真實目標(biāo)參數(shù)和相應(yīng)原始測量數(shù)據(jù)構(gòu)成的訓(xùn)練集,利用ANN建立了它們的映射關(guān)系,從訓(xùn)練數(shù)據(jù)集中學(xué)習(xí)網(wǎng)絡(luò)參數(shù)以解決光學(xué)計量中的逆問題[圖9]。相比于傳統(tǒng)的光學(xué)計量技術(shù),深度學(xué)習(xí)將主動策略從實際測量階段轉(zhuǎn)移到網(wǎng)絡(luò)訓(xùn)練階段,從而獲得了以下三項前所未有的優(yōu)勢:

1)從“模型驅(qū)動”到“數(shù)據(jù)驅(qū)動”:深度學(xué)習(xí)顛覆了傳統(tǒng)的“物理模型驅(qū)動”方式,并開啟了基于“數(shù)據(jù)驅(qū)動”的新范式。重建算法(逆映射)可以從實驗數(shù)據(jù)中學(xué)習(xí),而不需要有關(guān)物理模型的先驗知識。若訓(xùn)練數(shù)據(jù)集是在真實實驗環(huán)境下(包括測量系統(tǒng)、樣品類型、測量環(huán)境等)基于主動策略所采集的,且數(shù)據(jù)量充足(多樣性),那么訓(xùn)練出來的模型應(yīng)該能更精確、更全面地反映真實情況,因此通常會比傳統(tǒng)基于物理模型的方法得到更準(zhǔn)確的重建結(jié)果。

(2)從“分步分治”到“端到端學(xué)習(xí)”:與傳統(tǒng)的獨立解決任務(wù)序列的傳統(tǒng)光學(xué)計量方法相比,深度學(xué)習(xí)允許“端到端”學(xué)習(xí)結(jié)構(gòu),其中神經(jīng)網(wǎng)絡(luò)可以一步學(xué)習(xí)原始圖像數(shù)據(jù)與所需樣本參數(shù)之間的直接映射關(guān)系,如圖10所示。與“分步分治”方案相比,“端到端”學(xué)習(xí)方法具有協(xié)同作用的優(yōu)點:它能夠在執(zhí)行不同任務(wù)的網(wǎng)絡(luò)部分之間共享信息(特征),與獨立解決每個任務(wù)相比有助于獲得更好的整體性能。

(3)從“求解線性逆問題”到“直接學(xué)習(xí)偽逆映射”:深度學(xué)習(xí)利用復(fù)雜的神經(jīng)網(wǎng)絡(luò)結(jié)構(gòu)和非線性激活函數(shù)來提取樣本數(shù)據(jù)的高維特征,直接學(xué)習(xí)一個能夠充分描述整個測量過程(從原始圖像到待測物理量)的非線性偽逆映射模型(“重建算法”)。對于比傳統(tǒng)方法的正則化函數(shù)或指定先驗,深度學(xué)習(xí)所學(xué)習(xí)到的先驗信息是針對真實實驗數(shù)據(jù)的統(tǒng)計量身定制的,這原則上為求解反問題提供了更強(qiáng)、更合理的正則化。因此其繞過了求解非線性病態(tài)逆問題的障礙,可以直接建立輸入與期望輸出之間的偽逆映射關(guān)系。

圖9 基于深度學(xué)習(xí)的光學(xué)計量技術(shù)

a) 在基于深度學(xué)習(xí)的光學(xué)計量技術(shù)中,通過構(gòu)建一個深度神經(jīng)網(wǎng)絡(luò)從數(shù)據(jù)集中學(xué)習(xí)圖像空間到參數(shù)空間的映射關(guān)系 b) 通過實驗或仿真獲得訓(xùn)練數(shù)據(jù)集的過程。

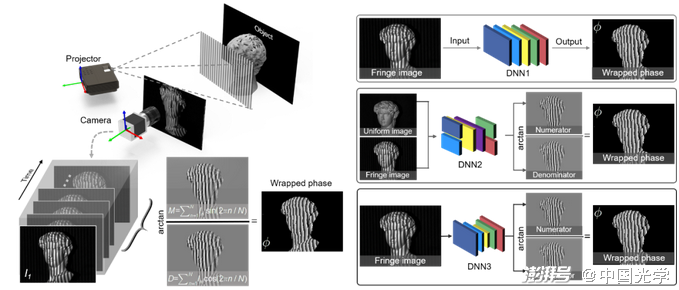

圖10 深度學(xué)習(xí)與傳統(tǒng)算法在條紋投影領(lǐng)域的對比

a) 條紋投影輪廓術(shù)的基本原理是基于光學(xué)三角測量法的三維重建(左)。其步驟一般包括條紋投影、相位恢復(fù)、相位展開和相位-高度映射 b) 基于深度學(xué)習(xí)的條紋投影輪廓術(shù)是由大量訓(xùn)練數(shù)據(jù)所驅(qū)動的,經(jīng)訓(xùn)練后的網(wǎng)絡(luò)模型可以直接從單幀條紋中預(yù)測出其中所編碼的深度信息

深度學(xué)習(xí)在光學(xué)計量學(xué)中的應(yīng)用

圖像處理算法的全面革新

由于上述優(yōu)點,深度學(xué)習(xí)在光學(xué)計量中受到越來越多的關(guān)注,為光學(xué)計量技術(shù)的概念帶來了顛覆性的變革。深度學(xué)習(xí)摒棄了對傳統(tǒng)“正向物理模型”和“逆向重構(gòu)算法”的嚴(yán)格依賴,以“樣本數(shù)據(jù)驅(qū)動”的方式重塑了幾乎所有光學(xué)計量技術(shù)中數(shù)字圖像處理的基本任務(wù),打破了傳統(tǒng)光學(xué)計量技術(shù)的功能/性能疆界,從極少的原始圖像數(shù)據(jù)中挖掘出更多場景的本質(zhì)信息,顯著提升了信息獲取能力,為光學(xué)計量技術(shù)打開了一扇新的大門。圖11回顧了在光學(xué)計量領(lǐng)域采用深度學(xué)習(xí)技術(shù)的典型研究工作。下面按照傳統(tǒng)光學(xué)計量技術(shù)的圖像處理層次列舉深度學(xué)習(xí)在光學(xué)計量學(xué)中的具體應(yīng)用案例。

圖11 光學(xué)計量中的深度學(xué)習(xí):由于深度學(xué)習(xí)為光學(xué)計量技術(shù)從概念上所帶來了重大改變,光學(xué)計量學(xué)中幾乎所有任務(wù)的實現(xiàn)方式都被深度學(xué)習(xí)所革新

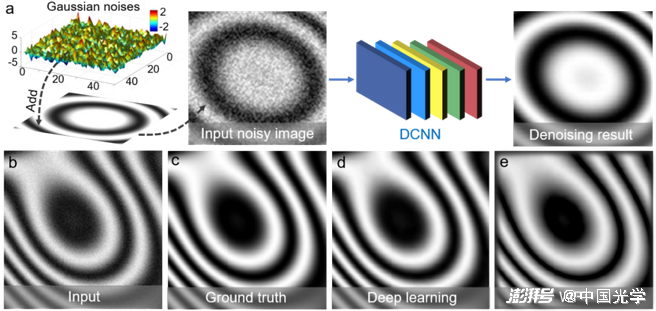

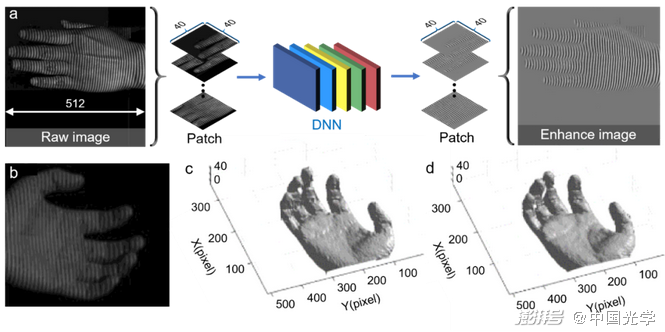

(1)圖像預(yù)處理:早期將深度學(xué)習(xí)應(yīng)用于光學(xué)計量的工作集中于圖像預(yù)處理任務(wù),如圖像去噪3?、圖像增強(qiáng)3?等。Yan等3?構(gòu)建了一個由20個卷積層組成的CNN來實現(xiàn)條紋圖像去噪[圖12a]。由于無噪聲的理想條紋圖像很難通過實驗獲取,他們仿真了大量添加高斯噪聲的條紋圖像(網(wǎng)絡(luò)輸入)和相應(yīng)的無噪聲數(shù)據(jù)(真值)用作神經(jīng)網(wǎng)絡(luò)的訓(xùn)練集。圖12d-圖12e給出傳統(tǒng)去噪方法——加窗傅里葉變換法(WFT3?)與深度學(xué)習(xí)方法的去噪結(jié)果。從結(jié)果中可見,基于深度學(xué)習(xí)的方法克服了傳統(tǒng)WFT的邊緣偽影,表現(xiàn)出更好的去噪性能。Shi等3?提出一種基于深度學(xué)習(xí)的條紋信息增強(qiáng)方法[圖13a]。他們將真實場景中捕獲的條紋圖像和相應(yīng)的質(zhì)量增強(qiáng)圖像(通過將兩幅相移量為π的條紋圖像相減獲取)用作數(shù)據(jù)集訓(xùn)練神經(jīng)網(wǎng)絡(luò),以實現(xiàn)對條紋圖像到質(zhì)量增強(qiáng)條紋信息之間的直接映射。圖13b-圖13d顯示了傳統(tǒng)傅里葉變換法(FT)3?和深度學(xué)習(xí)方法對運動的手的三維重建結(jié)果,從中可見深度學(xué)習(xí)方法在成像質(zhì)量上明顯優(yōu)于傳統(tǒng)方法。

圖12 基于深度學(xué)習(xí)的條紋圖像去噪方法及不同方法的去噪結(jié)果3?

a) 使用深度學(xué)習(xí)進(jìn)行條紋去噪的流程:將帶有噪聲的條紋圖像作為神經(jīng)網(wǎng)絡(luò)的輸入,直接預(yù)測去噪后的圖像 b) 輸入噪聲圖像 c) 真實相位分布 d) 深度學(xué)習(xí)的去噪結(jié)果 e) WFT3?的去噪結(jié)果

圖13 基于深度學(xué)習(xí)的條紋信息增強(qiáng)方法及不同方法下的三維重建結(jié)果3?

a) 使用深度學(xué)習(xí)進(jìn)行條紋信息增加的流程:采集的原始條紋圖像和質(zhì)量增強(qiáng)圖像被用來訓(xùn)練DNN,以學(xué)習(xí)輸入條紋圖像到輸出質(zhì)量增強(qiáng)條紋信息之間的映射 b) 輸入條紋圖像 c) 傳統(tǒng)FT法38的三維重建結(jié)果 d) 深度學(xué)習(xí)方法的三維重建結(jié)果

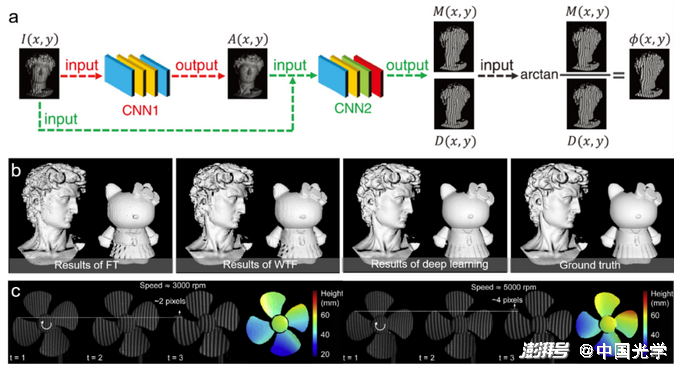

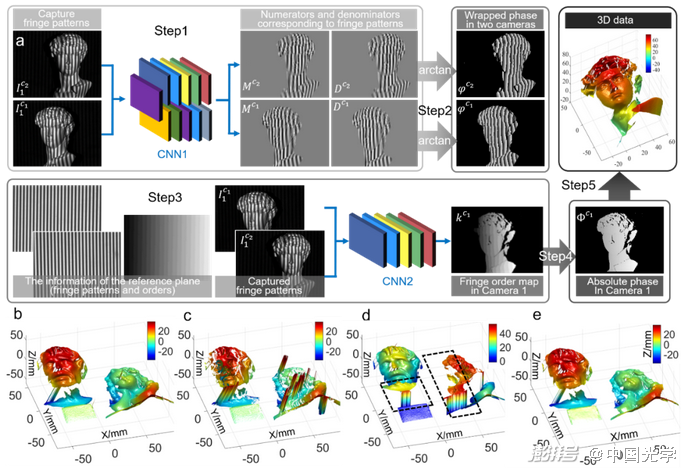

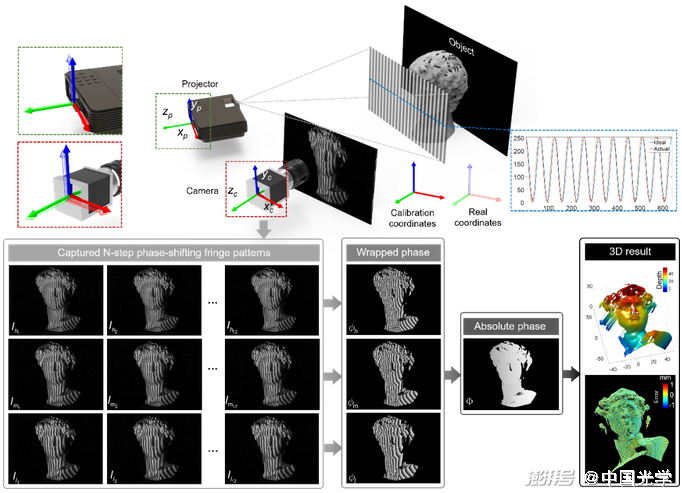

(2)圖像分析:圖像分析是光學(xué)計量技術(shù)中最核心的圖像處理環(huán)節(jié),因此大多數(shù)應(yīng)用于光學(xué)計量學(xué)的深度學(xué)習(xí)技術(shù)都是為了處理與圖像分析相關(guān)的任務(wù)。對于相位測量技術(shù),深度學(xué)習(xí)在相位解調(diào)和相位解包裹方面得到了廣泛的探索。Zuo等3?首次將深度學(xué)習(xí)技術(shù)應(yīng)用于條紋分析中,并有效提高了FPP的三維測量精度。該方法的思想在于僅采用一幅條紋圖像作為輸入,利用CNN來模擬傳統(tǒng)相移法1?的相位解調(diào)過程。如圖14a所示,構(gòu)建兩個卷積神經(jīng)網(wǎng)絡(luò)(CNN1和CNN 2),其中CNN 1負(fù)責(zé)從輸入條紋圖像(I)中提取背景信息(A);隨后CNN 2利用提取的背景圖像和原始輸入圖像生成所需相位的正弦部分(M)與余弦部分(D);最后,將該輸出的正余弦結(jié)果代入反正切函數(shù)計算得到最終的相位分布。相比于傳統(tǒng)單幀相位解調(diào)方法 (FT3?和WFT3?),基于深度學(xué)習(xí)的方法能夠更為準(zhǔn)確地提取相位信息,特別是針對具有豐富細(xì)節(jié)的物體表面,相位精度可提升50%以上,僅采用一幅輸入條紋圖像但總體測量效果接近于12步相移法[圖14b]。該技術(shù)目前已被成功應(yīng)用于高速三維成像,實現(xiàn)了速度高達(dá)20000Hz的高精度三維面型測量??[圖14c]。Zuo等還進(jìn)一步將深度學(xué)習(xí)從相位解調(diào)推廣至相位展開,提出一種用于單幀三維形貌測量的基于深度學(xué)習(xí)的幾何相位展開方法?1。如圖15a所示,多視幾何系統(tǒng)下捕獲的立體條紋圖像對及參考面信息被送入CNN中以確定條紋級次。圖15b-圖15e給出了傳統(tǒng)幾何相位展開方法?2???和深度學(xué)習(xí)方法獲得的三維重建結(jié)果。這些結(jié)果表明,基于深度學(xué)習(xí)的方法在僅投影單幀條紋圖像的前提下,可以在更大的測量體積內(nèi)、更魯棒地實現(xiàn)對稠密條紋圖像的相位展開。

圖14基于深度學(xué)習(xí)的條紋分析方法及不同方法下的三維重建結(jié)果3? a) 基于深度學(xué)習(xí)的條紋分析方法流程:首先通過CNN1從單幀條紋圖像I中預(yù)測出背景圖像A;然后采用CNN2實現(xiàn)條紋圖案I、背景圖像A與生成所需相位的正弦部分M和余弦部分D之間的映射;最后通過正切函數(shù)可以得到高精度包裹相位信息 b) 不同相位解調(diào)方法(FT3?、WFT3?、基于深度學(xué)習(xí)的方法和12步相移法13)的三維重建的比較 c) 使用深度學(xué)習(xí)方法對高速旋轉(zhuǎn)的臺扇的深度重建結(jié)果??

圖15基于深度學(xué)習(xí)的幾何相位展開方法及不同方法下的三維重建結(jié)果?1 a) 由深度學(xué)習(xí)輔助的幾何相位展開方法的流程:CNN1從立體條紋圖像對中預(yù)測包裹相位信息,CNN2從立體條紋圖像對及參考信息中預(yù)測條紋級次。通過預(yù)測的包裹相位和條紋級次可以恢復(fù)絕對相位,然后進(jìn)行三維重建 b) 結(jié)合相移法13、三相機(jī)幾何相位展開技術(shù)?2和自適應(yīng)深度約束法??獲取的三維重建結(jié)果 c)結(jié)合相移法13、雙相機(jī)幾何相位展開技術(shù)?2獲取的三維重建結(jié)果 d)基于參考面的幾何約束方法?3獲取的三維重建結(jié)果 e)深度學(xué)習(xí)方法獲取的三維重建結(jié)果

深度學(xué)習(xí)也被廣泛應(yīng)用于立體匹配,并獲得比傳統(tǒng)子集匹配和亞像素優(yōu)化方法更好的性能。Zbontar和LeCun??提出一種用于立體圖像視差估計的深度學(xué)習(xí)方法[圖16]。他們構(gòu)建了一個暹羅型CNN,通過從兩個圖像塊中學(xué)習(xí)相似度量來解決匹配成本計算問題。CNN的輸出被用于初始化立體匹配成本,然后通過基于交叉的成本聚合和半全局匹配精煉初始成本進(jìn)而實現(xiàn)視差圖估計。圖16d-圖16h是由傳統(tǒng)Census??變換法和深度學(xué)習(xí)方法獲取的視差圖像,從中可以看出,基于深度學(xué)習(xí)的方法實現(xiàn)了更低的錯誤率和更好的預(yù)測結(jié)果。Pang等??提出一種用于亞像素匹配的級聯(lián)CNN架構(gòu)。如圖17a所示,首先通過帶有上采樣模塊的DispFulNet從輸入立體圖像對中預(yù)測初始視差估計,然后通過沙漏結(jié)構(gòu)的DispResNet生成多尺度的殘余信號,綜合兩網(wǎng)絡(luò)輸出最終獲取亞像素精度的視差圖。圖17d-圖17g展示了由DispfulNet和DispResNet預(yù)測的視差圖及誤差分布情況。從實驗結(jié)果可以看出,經(jīng)過第二階段DispResNet的優(yōu)化,視差圖的質(zhì)量得到了明顯的改善。

圖16 基于深度學(xué)習(xí)的子集匹配方法及不同方法的視差估計結(jié)果?? a) 使用深度學(xué)習(xí)進(jìn)行視差圖估計的算法流程:暹羅型CNN被構(gòu)建用于從兩個圖像塊中學(xué)習(xí)相似度量以解決匹配成本計算問題,并通過一系列后處理最終實現(xiàn)視差估計 b-c) 輸入的立體圖像 d) 真值 e, g) Census??和CNN獲取的視差估計結(jié)果

圖17 a) 基于深度學(xué)習(xí)的亞像素匹配方法:首先通過DispFulNet從輸入立體圖像對中預(yù)測初始視差估計,然后通過沙漏結(jié)構(gòu)的DispResNet生成多尺度的殘余信號,綜合兩網(wǎng)絡(luò)輸出最終獲取亞像素精度的視差圖?? b) 輸入立體圖像的左視角 c) 真值 d-g) DispfulNet和DispResNet預(yù)測的視差圖及誤差分布情況

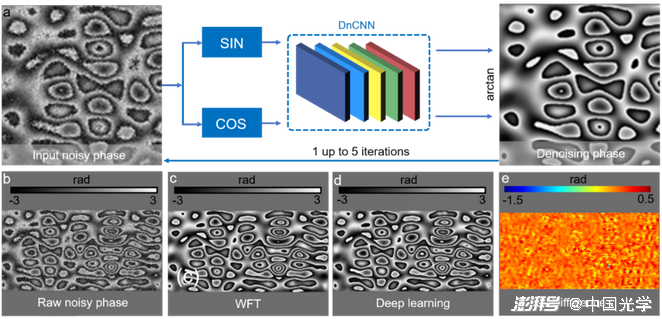

(3)后處理:深度學(xué)習(xí)在光學(xué)計量的后處理階段(相位去噪、誤差補(bǔ)償、數(shù)字重聚焦、相位-高度映射等)也發(fā)揮著重要作用。如圖18a所示,Montresor等??將噪聲相位圖像的正弦和余弦分量輸入CNN中以預(yù)測去除噪聲的高質(zhì)量相位圖像,預(yù)測的相位被再次反饋到CNN中進(jìn)行迭代提煉以達(dá)到更好的去噪效果。圖18b-圖18e給出了傳統(tǒng)WFT3?法和深度學(xué)習(xí)方法的相位去噪結(jié)果。實驗結(jié)果表明CNN能夠?qū)崿F(xiàn)比WFT峰谷相位誤差更低的去噪性能。

圖18 基于深度學(xué)習(xí)的相位去噪方法及不同方法的相位去噪結(jié)果?? a) 使用深度學(xué)習(xí)進(jìn)行相位去噪的流程:噪聲相位圖像的正弦和余弦分量被輸入CNN以預(yù)測去除噪聲的高質(zhì)量相位圖像,預(yù)測的相位被再次反饋到CNN中進(jìn)行迭代提煉以達(dá)到更好的去噪效果 b) 輸入噪聲相位圖像 c) WTF3?的去噪結(jié)果 d) 深度學(xué)習(xí)的去噪結(jié)果 e) WTF與深度學(xué)習(xí)方法去噪結(jié)果的對比

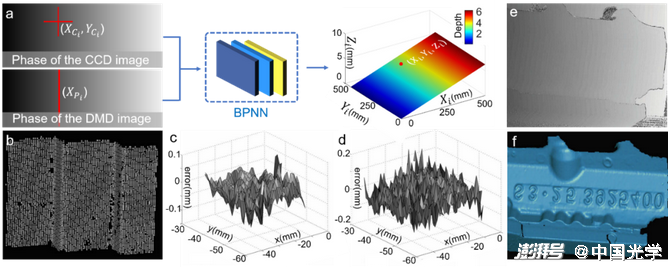

Li等??提出了一種基于淺層BP神經(jīng)網(wǎng)絡(luò)的用于條紋投影輪廓術(shù)的相位-高度映射方法。如圖19a所示,相機(jī)圖像坐標(biāo)及對應(yīng)的投影儀圖像水平坐標(biāo)被用作網(wǎng)絡(luò)輸入以預(yù)測被測物的三維信息。為了獲取訓(xùn)練數(shù)據(jù),將圓點標(biāo)定板固定于高精度位移臺并在不同的深度位置處捕獲標(biāo)定板的條紋圖像。通過提取標(biāo)定板圓點的亞像素中心,并利用絕對相位計算每個標(biāo)記中心對應(yīng)的相機(jī)和投影儀圖像的匹配點。圖19c和圖19d是由傳統(tǒng)相高轉(zhuǎn)換方法??和神經(jīng)網(wǎng)絡(luò)方法獲取的階梯狀標(biāo)準(zhǔn)件三維面型結(jié)果的誤差分布情況,該結(jié)果表明基于神經(jīng)網(wǎng)絡(luò)的方法可以從大量數(shù)據(jù)中學(xué)習(xí)出更加準(zhǔn)確的相高模型。

圖19 a) 基于學(xué)習(xí)的相位-深度映射方法:相機(jī)圖像坐標(biāo)及對應(yīng)的投影儀圖像的水平坐標(biāo)被用作網(wǎng)絡(luò)輸入以預(yù)測被測物的三維信息?? b) 基于學(xué)習(xí)的方法獲取的階梯狀標(biāo)準(zhǔn)件的三維結(jié)果 c、d) 傳統(tǒng)相高轉(zhuǎn)換方法??和神經(jīng)網(wǎng)絡(luò)方法獲取的階梯狀標(biāo)準(zhǔn)件三維面型結(jié)果的誤差分布情況 e、f) 復(fù)雜工件的輸入相位圖像及輸出三維信息

深度學(xué)習(xí)在光學(xué)計量領(lǐng)域面臨的挑戰(zhàn)與機(jī)遇

目前,深度學(xué)習(xí)已逐漸“滲透”進(jìn)了計算成像與光學(xué)測量這一學(xué)科中,并在條紋分析、相位恢復(fù)、相位展開等方面展現(xiàn)出令人驚嘆的性能以及強(qiáng)大的應(yīng)用潛力。然而,目前深度學(xué)習(xí)在光學(xué)計量領(lǐng)域仍然面臨諸多挑戰(zhàn):

(1) 深度學(xué)習(xí)作為一種數(shù)據(jù)驅(qū)動的技術(shù),其網(wǎng)絡(luò)輸出的性能很大程度上取決于大量標(biāo)記的訓(xùn)練數(shù)據(jù)。而大部分光學(xué)計量實驗的數(shù)據(jù)采集過程較為復(fù)雜耗時,且往往數(shù)據(jù)采集后無法獲取準(zhǔn)確可靠的理想真值[圖20]。

圖20 深度學(xué)習(xí)在光學(xué)計量中的挑戰(zhàn)-——獲取和標(biāo)注訓(xùn)練數(shù)據(jù)的高昂代價。以條紋投影輪廓術(shù)為例,采用多頻時間相位展開法以投影大量條紋圖像為代價獲取高質(zhì)量訓(xùn)練數(shù)據(jù)。然而在實際操作中,硬件誤差、環(huán)境光干擾、標(biāo)定誤差等因素使得通過傳統(tǒng)的算法很難獲取理想真值

(2) 到目前為止,仍然沒有任何理論可以清楚地解釋針對特定的成像需求,到底選擇什么樣結(jié)構(gòu)的神經(jīng)網(wǎng)絡(luò)最為合適[圖21]?

(3) 深度學(xué)習(xí)的成功通常取決于從訓(xùn)練樣本中學(xué)習(xí)和提取的“共同”特征作為先驗信息。因此,當(dāng)人工神經(jīng)網(wǎng)絡(luò)面對“罕見樣本”時,它極易給出一個錯誤的預(yù)測結(jié)果并且毫無察覺。

(4) 不同于傳統(tǒng)基于物理模型方法“透明式”推演過程,當(dāng)前大多數(shù)基于深度學(xué)習(xí)方法的決策過程通常被認(rèn)為是由訓(xùn)練數(shù)據(jù)所驅(qū)動的“黑匣子”。而在光學(xué)計量中,可解釋性往往至關(guān)重要,因其確保了錯誤的可追溯性。

(5) 由于信息并不會"無中生有",深度學(xué)習(xí)所獲得的結(jié)果不可能總是準(zhǔn)確可靠的。這對于光學(xué)測量的許多應(yīng)用領(lǐng)域而言往往是致命性的,如逆向工程、自動控制、缺陷檢測等。在這些場合,測量結(jié)果的準(zhǔn)確性、可靠性、可重復(fù)性以及可回溯性是首要考慮的因素。

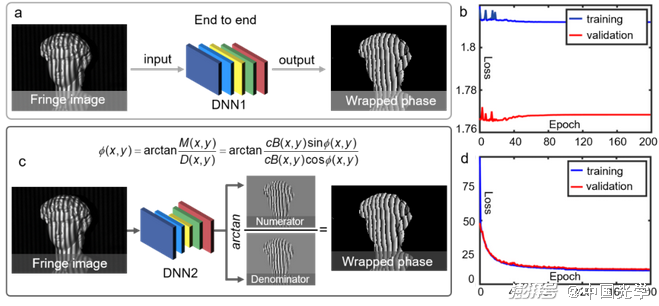

圖21 深度學(xué)習(xí)在光學(xué)計量中的挑戰(zhàn)——模型設(shè)計和算法選擇的經(jīng)驗主義。以條紋投影輪廓術(shù)中的相位提取為例,同一任務(wù)可以由不同的神經(jīng)網(wǎng)絡(luò)模型以不同的策略來實現(xiàn):通過DNN1可以將條紋圖像直接映射到相應(yīng)的相位圖;也可通過DNN2從條紋圖像和相應(yīng)的背景圖像中輸出用于計算相位信息的正切函數(shù)的分子項和分母項;使用更強(qiáng)大的DNN,可直接從條紋圖像中預(yù)測分子和分母

盡管上述挑戰(zhàn)還沒有得到充分解決,隨著計算機(jī)科學(xué)與人工智能技術(shù)的進(jìn)一步發(fā)展,可預(yù)計未來深度學(xué)習(xí)將通過以下三個方面在光學(xué)計量中發(fā)揮愈發(fā)突出的作用:

(1) 搭載深度學(xué)習(xí)技術(shù)發(fā)展的“順風(fēng)車”,將其中的新興技術(shù)(如對抗學(xué)習(xí)、遷移學(xué)習(xí)、自動化機(jī)器學(xué)習(xí)等)運用到光學(xué)計量領(lǐng)域,可以促進(jìn)深度學(xué)習(xí)在光學(xué)計量領(lǐng)域中的廣泛接受與認(rèn)可。

(2) 將貝葉斯統(tǒng)計學(xué)與深度神經(jīng)網(wǎng)絡(luò)相結(jié)合以對估計結(jié)果的不確定性進(jìn)行估計與量化,基于此可以評估神經(jīng)網(wǎng)絡(luò)何時產(chǎn)生不可靠的預(yù)測?1。這在“盲目信任”與“全盤否定”之間給了研究人員另一種可能的選擇,即“選擇性”采納。

(3) 描述圖像生成的先驗知識與物理模型和從實驗數(shù)據(jù)中學(xué)習(xí)的數(shù)據(jù)驅(qū)動模型二者間協(xié)同作用,能夠?qū)⒐鈱W(xué)計量領(lǐng)域的更多專業(yè)知識引入深度學(xué)習(xí)框架中,為解決特定的光學(xué)計量問題提供更多高效且“物理上合理”的解決方案[圖22]。

圖22 將物理模型引入深度學(xué)習(xí)可為特定光學(xué)計量問題提供更為“合乎情理”的解決方案。a) 基于端到端網(wǎng)絡(luò)結(jié)構(gòu)(DNN1)從條紋圖像中直接預(yù)測包裹相位 b) 端到端策略很難精準(zhǔn)復(fù)現(xiàn)2π相位截斷,導(dǎo)致網(wǎng)絡(luò)的損失函數(shù)訓(xùn)練時無法收斂 c) 將傳統(tǒng)相移法的物理模型納入深度學(xué)習(xí),從條紋圖像中預(yù)測用于計算相位信息的正切函數(shù)的分子項和分母項39 d) 結(jié)合物理模型的深度學(xué)習(xí)網(wǎng)絡(luò)的損失函數(shù)訓(xùn)練時可穩(wěn)定收斂

總結(jié)與展望

毋庸置疑,深度學(xué)習(xí)技術(shù)為解決光學(xué)計量領(lǐng)域的諸多挑戰(zhàn)性問題提供了性能強(qiáng)大且具有發(fā)展?jié)摿Φ娜陆鉀Q方案,并促進(jìn)了光學(xué)計量學(xué)從“基于物理和知識的建模”向“基于數(shù)據(jù)驅(qū)動的學(xué)習(xí)”范式的轉(zhuǎn)變。大量已發(fā)表的文獻(xiàn)結(jié)果表明,針對特定問題通常基于深度學(xué)習(xí)的方法能夠提供優(yōu)于傳統(tǒng)的基于知識或物理模型的方法的性能,特別是針對許多物理模型復(fù)雜且所能獲得的信息量有限的光學(xué)計量任務(wù)。

但不得不承認(rèn),目前深度學(xué)習(xí)技術(shù)在光學(xué)測量領(lǐng)域仍處于發(fā)展的早期階段。該領(lǐng)域中相當(dāng)一部分研究人員是嚴(yán)謹(jǐn)且理性的,他們對現(xiàn)階段缺乏可解釋性的“黑匣子”式的深度學(xué)習(xí)解決方案是抱有質(zhì)疑的,且對其在工業(yè)檢測和生物醫(yī)療等方面的應(yīng)用是持觀望態(tài)度的。我們應(yīng)該全盤接受深度學(xué)習(xí)作為我們解決問題“殺手锏”,還是拒絕這樣的“黑匣子”解決方案?這是當(dāng)前光學(xué)計量界極具爭議的問題。

從正面來看,深度學(xué)習(xí)的出現(xiàn)為光學(xué)計量這一“傳統(tǒng)”領(lǐng)域帶來新的“生機(jī)”。它在光學(xué)計量領(lǐng)域的“全面滲透”也向我們展示了人工智能技術(shù)為光學(xué)計量領(lǐng)域帶來巨大的變革的可能性。反過來,我們也不該高估深度學(xué)習(xí)的力量,并把它當(dāng)作解決光學(xué)計量未來發(fā)展所遇到的每個挑戰(zhàn)的“萬能鑰匙”。在具體實踐中,我們應(yīng)理智地評估將深度學(xué)習(xí)用于特定任務(wù)所需的大量數(shù)據(jù)資源、計算資源和時間成本是否值得。特別是針對很多并不是那么“嚴(yán)苛”的應(yīng)用場合,傳統(tǒng)基于物理模型與“主動策略”的技術(shù)能夠以更低的復(fù)雜度和更高的可解釋性獲得更好的結(jié)果時,我們勇于對深度學(xué)習(xí)說“不”!

在未來幾年內(nèi),深度學(xué)習(xí)是否會取代傳統(tǒng)技術(shù)在光學(xué)計量領(lǐng)域的角色,發(fā)揮顛覆性的作用?很明顯,沒有人可以預(yù)測未來,但我們可以參與其中。不管您是光學(xué)計量領(lǐng)域鐘情于傳統(tǒng)技術(shù)的“老司機(jī)”,還是在該領(lǐng)域涉足不久的“新手上路”,我們都鼓勵您能夠搭上這趟“順風(fēng)車”—— 去大膽地嘗試一下深度學(xué)習(xí)吧!因為它真的很簡單,而且往往很奏效!

附注:本文附帶了一個深度學(xué)習(xí)用于單幀條紋分析的示例程序(Supplemental Material File #1)及其詳細(xì)的步驟指南(Supplementary Information),以方便讀者的學(xué)習(xí)與理解。更多本文相關(guān)的詳細(xì)內(nèi)容,請點擊 https://www.nature.com/articles/s41377-022-00714-x 來閱讀全長54頁的論文正文。

論文信息

Zuo, C., Qian, J., Feng, S. et al. Deep learning in optical metrology: a review. Light Sci Appl 11, 39 (2022).

https://doi.org/10.1038/s41377-022-00714-x

本文第一作者為南京理工大學(xué)左超教授,南京理工大學(xué)博士生錢佳銘為共一作者,合著者包括南京理工大學(xué)馮世杰副教授、南京理工大學(xué)博士生尹維、南京理工大學(xué)博士生李藝璇、英國倫敦瑪麗女王大學(xué)博士生樊鵬飛、南京理工大學(xué)韓靜副教授、新加坡南洋理工大學(xué)錢克矛教授、南京理工大學(xué)陳錢教授。

參考文獻(xiàn)

1.G?svik, K. J. Optical metrology. (John Wiley & Sons, 2003).

2.Creath, K. V phase-measurement interferometry techniques. in Progress in optics vol. 26 349–393 (Elsevier, 1988).

3.Aben, H. & Guillemet, C. Integrated photoelasticity. in Photoelasticity of Glass 86–101 (Springer, 1993).

4.Gabor, D. A new microscopic principle. nature 161, 777–778 (1948).

5.Schnars, U., Falldorf, C., Watson, J. & Jüptner, W. Digital holography. in Digital Holography and Wavefront Sensing 39–68 (Springer, 2015).

6.Gorthi, S. S. & Rastogi, P. Fringe projection techniques: whither we are? Opt. Lasers Eng. 48, 133–140 (2010).

7.Pan, B., Qian, K., Xie, H. & Asundi, A. Two-dimensional digital image correlation for in-plane displacement and strain measurement: a review. Meas. Sci. Technol. 20, 062001 (2009).

8.Marr, D. & Poggio, T. A computational theory of human stereo vision. Proc. R. Soc. Lond. B Biol. Sci. 204, 301–328 (1979).

9.Pitas, I. Digital image processing algorithms and applications. (John Wiley & Sons, 2000).

10.Trusiak, M., Patorski, K. & Wielgus, M. Adaptive enhancement of optical fringe patterns by selective reconstruction using FABEMD algorithm and Hilbert spiral transform. Opt. Express 20, 23463–23479 (2012).

11.Awatsuji, Y. et al. Single-shot phase-shifting color digital holography. in LEOS 2007-IEEE Lasers and Electro-Optics Society Annual Meeting Conference Proceedings 84–85 (IEEE, 2007).

12.Fusiello, A., Trucco, E. & Verri, A. A compact algorithm for rectification of stereo pairs. Mach. Vis. Appl. 12, 16–22 (2000).

13.Zuo, C. et al. Phase shifting algorithms for fringe projection profilometry: A review. Opt. Lasers Eng. 109, 23–59 (2018).

14.Zuo, C., Huang, L., Zhang, M., Chen, Q. & Asundi, A. Temporal phase unwrapping algorithms for fringe projection profilometry: A comparative review. Opt. Lasers Eng. 85, 84–103 (2016).

15.Konolige, K. Small vision systems: Hardware and implementation. in Robotics research 203–212 (Springer, 1998).

16.Hong, C. K., Ryu, H. S. & Lim, H. C. Least-squares fitting of the phase map obtained in phase-shifting electronic speckle pattern interferometry. Opt. Lett. 20, 931–933 (1995).

17.Zuo, C., Chen, Q., Qu, W. & Asundi, A. Phase aberration compensation in digital holographic microscopy based on principal component analysis. Opt. Lett. 38, 1724–1726 (2013).

18.Langehanenberg, P., Kemper, B., Dirksen, D. & Von Bally, G. Autofocusing in digital holographic phase contrast microscopy on pure phase objects for live cell imaging. Appl. Opt. 47, D176–D182 (2008).

19.Wang, Y. & Zhang, S. Optimal fringe angle selection for digital fringe projection technique. Appl. Opt. 52, 7094–7098 (2013).

20.McCulloch, W. S. & Pitts, W. A logical calculus of the ideas immanent in nervous activity. Bull. Math. Biophys. 5, 115–133 (1943).

21.Rosenblatt, F. The perceptron: a probabilistic model for information storage and organization in the brain. Psychol. Rev. 65, 386 (1958).

22.Rumelhart, D. E., Hinton, G. E. & Williams, R. J. Learning representations by back-propagating errors. nature 323, 533–536 (1986).

23.LeCun, Y. et al. Backpropagation applied to handwritten zip code recognition. Neural Comput. 1, 541–551 (1989).

24.Hinton, G. E., Osindero, S. & Teh, Y.-W. A fast learning algorithm for deep belief nets. Neural Comput. 18, 1527–1554 (2006).

25.Krizhevsky, A., Sutskever, I. & Hinton, G. E. ImageNet classification with deep convolutional neural networks. Commun. ACM 60, 84–90 (2017).

26.Nair, V. & Hinton, G. E. Rectified linear units improve restricted boltzmann machines. in ICML (2010).

27.Hinton, G. E., Srivastava, N., Krizhevsky, A., Sutskever, I. & Salakhutdinov, R. R. Improving neural networks by preventing co-adaptation of feature detectors. ArXiv Prepr. ArXiv12070580 (2012).

28.Chen, J. X. The evolution of computing: AlphaGo. Comput. Sci. Eng. 18, 4–7 (2016).

29.LeCun, Y., Bengio, Y. & Hinton, G. Deep learning. Nature 521, 436–444 (2015).

30.Ouyang, W. et al. DeepID-Net: Object detection with deformable part based convolutional neural networks. IEEE Trans. Pattern Anal. Mach. Intell. 39, 1320–1334 (2016).

31.Doulamis, N. & Voulodimos, A. FAST-MDL: Fast Adaptive Supervised Training of multi-layered deep learning models for consistent object tracking and classification. in 2016 IEEE International Conference on Imaging Systems and Techniques (IST) 318–323 (IEEE, 2016).

32.Dong, C., Loy, C. C., He, K. & Tang, X. Image super-resolution using deep convolutional networks. IEEE Trans. Pattern Anal. Mach. Intell. 38, 295–307 (2015).

33.Long, J., Shelhamer, E. & Darrell, T. Fully convolutional networks for semantic segmentation. in Proceedings of the IEEE conference on computer vision and pattern recognition 3431–3440 (2015).

34.Ronneberger, O., Fischer, P. & Brox, T. U-net: Convolutional networks for biomedical image segmentation. in International Conference on Medical image computing and computer-assisted intervention 234–241 (Springer, 2015).

35.Yan, K. et al. Fringe pattern denoising based on deep learning. Opt. Commun. 437, 148–152 (2019).

36.Shi, J., Zhu, X., Wang, H., Song, L. & Guo, Q. Label enhanced and patch based deep learning for phase retrieval from single frame fringe pattern in fringe projection 3D measurement. Opt. Express 27, 28929 (2019).

37.Kemao, Q. Windowed Fourier transform for fringe pattern analysis. Appl. Opt. 43, 2695–2702 (2004).

38.Takeda, M., Ina, H. & Kobayashi, S. Fourier-transform method of fringe-pattern analysis for computer-based topography and interferometry. JosA 72, 156–160 (1982).

39.Feng, S. et al. Fringe pattern analysis using deep learning. Adv. Photonics 1, 025001 (2019).

40.Feng, S., Zuo, C., Yin, W., Gu, G. & Chen, Q. Micro deep learning profilometry for high-speed 3D surface imaging. Opt. Lasers Eng. 121, 416–427 (2019).

41.Qian, J. et al. Deep-learning-enabled geometric constraints and phase unwrapping for single-shot absolute 3D shape measurement. APL Photonics 5, 046105 (2020).

42.Tao, T. et al. Real-time 3-D shape measurement with composite phase-shifting fringes and multi-view system. Opt. Express 24, 20253 (2016).

43.An, Y., Hyun, J.-S. & Zhang, S. Pixel-wise absolute phase unwrapping using geometric constraints of structured light system. Opt. Express 24, 18445–18459 (2016).

44.Tao, T. et al. High-speed real-time 3D shape measurement based on adaptive depth constraint. Opt. Express 26, 22440 (2018).

45.Zˇbontar, J. & LeCun, Y. Stereo matching by training a convolutional neural network to compare image patches. 32.

46.Mei, X. et al. On building an accurate stereo matching system on graphics hardware. in 2011 IEEE International Conference on Computer Vision Workshops (ICCV Workshops) 467–474 (IEEE, 2011).

47.Pang, J., Sun, W., Ren, J. SJ., Yang, C. & Yan, Q. Cascade Residual Learning: A Two-Stage Convolutional Neural Network for Stereo Matching. in 2017 IEEE International Conference on Computer Vision Workshops (ICCVW) 878–886 (IEEE, 2017). doi:10.1109/ICCVW.2017.108.

48.Montresor, S., Tahon, M., Laurent, A. & Picart, P. Computational de-noising based on deep learning for phase data in digital holographic interferometry. APL Photonics 5, 030802 (2020).

49.Li, Z., Shi, Y., Wang, C., Qin, D. & Huang, K. Complex object 3D measurement based on phase-shifting and a neural network. Opt. Commun. 282, 2699–2706 (2009).

50.Li, Z., Shi, Y., Wang, C. & Wang, Y. Accurate calibration method for a structured light system. Opt. Eng. 47, 053604 (2008).

51.Feng, S., Zuo, C., Hu, Y., Li, Y. & Chen, Q. Deep-learning-based fringe-pattern analysis with uncertainty estimation. Optica 8, 1507–1510 (2021).

文章轉(zhuǎn)載/商務(wù)合作/課題組投稿,微信:447882024

帶您每天讀1篇文獻(xiàn)!加入>Light讀書會

本文為澎湃號作者或機(jī)構(gòu)在澎湃新聞上傳并發(fā)布,僅代表該作者或機(jī)構(gòu)觀點,不代表澎湃新聞的觀點或立場,澎湃新聞僅提供信息發(fā)布平臺。申請澎湃號請用電腦訪問http://renzheng.thepaper.cn。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯(lián)網(wǎng)新聞信息服務(wù)許可證:31120170006

增值電信業(yè)務(wù)經(jīng)營許可證:滬B2-2017116

? 2014-2025 上海東方報業(yè)有限公司