- +1

AI社會學|至此,一個算法客觀的時代過去了

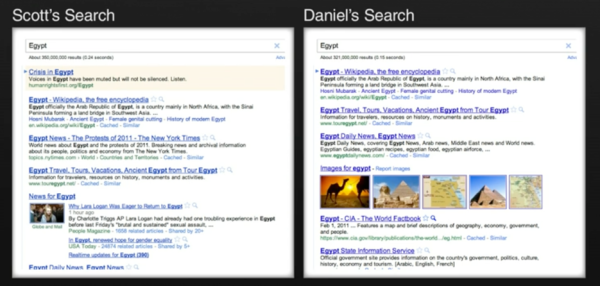

十年前,網紅伊萊·帕里澤(Eli Fariser)請他居住在紐約的朋友斯考特(Scott)和丹尼爾(Daniel)分別打開自己的谷歌首頁,搜索“埃及”這個地名。彼時,埃及正爆發1977年以來最大的民眾示威,要求總統穆巴拉克下臺。帕里澤驚奇地發現,同為居住在曼哈頓的白人男性,谷歌對斯考特和丹尼爾所展現的搜索結果截然不同:斯考特的結果里滿是有關“埃及革命”的實時新聞,風起云涌,硝煙四起;丹尼爾的首頁里則是埃及的駱駝、金字塔、夕陽晚景,一片歲月靜好。

圖片來源:Eli Fariser: Beware Online Filter Bubble, TED talk, 2011

斯考特和丹尼爾的經歷并非獨有。事實上,為了使用戶更長時間地停留在平臺之上,近十年來互聯網內容分發平臺的“推薦算法” (recommendation algorithms)愈演愈烈,各大網絡公司為了迎合用戶喜好,往往會基于過往行為數據,選擇性地推薦每個用戶最感興趣的內容。帕里澤用了一個形象的比喻來說明現代網絡經過算法設置之后展現在我們面前的圖景:“過濾氣泡” (The Filter Bubble)——在網絡高度發達的今天,每一個人都生活在一個私人的、經由算法過濾的信息氣泡里。

譬如,谷歌的個性化搜索服務無時無刻不在根據多達57個的變量(包括地址、網址,瀏覽器種類等等)來為用戶們定制他們專屬的搜索結果—— 斯考特和丹尼爾截然不同的搜索結果就是個性化算法的產物。臉書的信息流(news feed)則同樣精確地為用戶們推送算法認為“你此刻最感興趣”的社交信息——比如, 政治傾向偏左的帕里澤就發現他很少能見到保守派朋友的臉書分享。

我國頭條派的興起則將這一內容推薦算法推演到了另一個極致。你喜歡花花草草,我就給你更多的花花草草;你喜歡內涵段子,我就給你更多的內涵段子。頭條大佬張一鳴如是說—— “媒體是要有價值觀的,它要教育人、輸出主張,這個我們不提倡。因為我們不是媒體,我們更關注信息的吞吐量和信息的多元”。

“算法沒有價值觀”—— 只如實反映用戶個人的好惡。近十年來,算法的“客觀中立性”幾乎是所有互聯網內容分發平臺面對監管和社會批評的尚方寶劍。即使面對2016年美國大選的風起云涌、各種干涉選舉、傳播虛假信息的指控,臉書大佬馬克?扎克伯格仍敢對媒體嘴硬道:“我們是科技公司,不是傳媒公司,我們不對平臺上出現的內容負責”。科技只是一種工具, 而工具是無辜的。

這就像人和槍的比喻。一個人拿槍殺了人,你能怪槍嗎?

扎克伯格也許不讀科技社會學。他不知道類似的比喻已經是科技社會學里重復了一千遍的老梗。法國哲學家布魯?諾拉圖(Bruno Latour)就曾以此來說明人和科技之間的互動關系。一個人拿一把槍殺了人,那么是“槍殺人”,還是“人殺人”呢?學界曾為此爭論不休。技術中立派如扎克伯格會支持后者——槍只是工具,人才是真兇 ——科技本身不會作惡。拉圖則說,這是錯誤的。他認為,槍并非一種客觀的物體,而是在與持槍者的互動中將殺人這件事實現的。當一個人手上有一把槍,并用它來殺人時,這個人才變成“兇手”,這把槍也同時變成了“兇器”。在這個過程中,槍械和人是在互相改變的。“殺人”這一行為,既不只是一個人殺人意圖的結果,也不只是一把槍開火的結果,而是兩者聯結成的行動網絡的共同結果。

從這個角度來說,Technology is not a tool but a set of relations——技術并不僅僅是工具,而是一系列“關系”的集合。因此,也從來沒有過客觀中立和無價值觀的科技,科技在與社會關系的互動中生成進化,也永遠背負當時當地社會關系的烙印。

事實上,早在2014年,面對算法對人類知識文化的全方位殖民,康奈爾大學的傳播學者塔勒頓·吉萊斯皮(Tarleton Gillespie)就曾對算法的客觀性提出系統性的質疑。在這篇名為“算法的相關性”(The Relevance of Algorithms)的短文里,吉萊斯皮梳理了“公共算法” (public relevance algorithms)在現代信息生態系統里的六大面向,每一種都可能對政治產生毀滅性的影響。

其中至關重要的一點,是“算法自詡的客觀性” ——相較于人類編輯可能存在的情感、政治和社會的喜好和偏見,算法被平臺們許諾為“客觀”和“中立”的。因此,當內容分發平臺全面使用算法接管之前由人類編輯負責的部分時,所有曾經用來約束信息分發的道德、法律、社會契約被自動架空了。誠實、客觀、公正、可靠……這些西方新聞業在上個世紀前期經由一系列社會運動與自我反思與大眾達成的(短暫且不完美)共識變成了虛無縹緲的空中樓閣。畢竟,我們怎么能要求一堆冰冷的計算機程序“誠實、客觀、公正、可靠”呢?

在帕里澤看來,號稱客觀中立的算法恰恰是最危險的。他在這本出版于2011年的暢銷書《過濾氣泡》里(《The filter bubble: How the new personalized web is changing what we read and how we think》 )細梳理了“算法濾泡” 帶給現代社會的四大問題:

第一,推薦算法為你推送的是根據你的個人喜好和點擊習慣而精心調整的“個性化信息”—— 作為用戶,你失去了與其他信息接觸的渠道。隨著互聯網平臺逐步壟斷現代信息社會的入口,你的信息世界會越來越狹隘和偏頗。

第二,推薦算法同時會調整你的社會關系。譬如,臉書會自動推薦你和意氣相投的人和團體互動。和你世界觀人生觀價值觀不同的人群會漸漸從你的社交網絡消失,你的社會關系會變得同質化。

第三,推薦算法有侵犯隱私的危險。搜索引擎和社交網絡自動收集和分析你的每一次點擊和在每一條信息上停留的時間,生成用戶畫像。他們可能比你媽更了解你,而你將面臨無可遁形的危險。

第四,也是最可怕的,在整個過程中,用戶沒有說“不”的權力。硅谷新貴們相信“用戶需求”是可以被制造、被培育出來的。或者,更確切地說,他們覺得自己比用戶更了解用戶——你說你想讀莎士比亞,也許你真正想看的是一千零一遍的《甄嬛傳》?正如喬布斯所說:“用戶不知道他們想要什么......我們的工作就是告訴用戶他們需要什么”(“People don’t know what they want until you show it to them … Our job is to figure out what they’re going to want before they do.” )。

如果帕里澤在2011年提出算法的“過濾氣泡”僅僅是在一小批知識界引起反響,那么在十年后的今天,反思內容推薦算法所造成的后果已經成為大半個美國的共識。2016年特朗普意外贏得大選,比任何時刻更讓人們震驚于美國社會的撕裂以及號稱“客觀”和“去價值觀”的平臺算法對此的推波助瀾。有學者指出,由于互聯網公司將用戶在平臺停留時長作為首要KPI,算法常常會被設計成首先推送“博人眼球”的極端化言論。換言之,算法是有價值觀的,此時此地,它的價值觀是平臺利潤。谷歌、臉書、推特因此相繼成為美國國會聽證會的常客。連奈飛(Netflix)也乘熱打鐵地推出對社交網絡進行系統性批判的爆款短片《The Social Dilemma》。

公共政策學者更是明確指出:內容分發平臺自詡為“科技公司”而非“傳媒機構”一方面是在取悅科技投資者,另一方面則是在逃避監管。學者們認為,平臺們用來逃避“傳媒機構”定義的幾大借口統統都站不住腳。比如,平臺們號稱自己不生產內容,因而不是傳媒公司;而歷史上大批傳媒公司同時兼顧內容生產和內容分發,更別提臉書和谷歌日漸將各大內容生產平臺收入囊中了。

再比如,平臺們號稱自己不使用“人類編輯”,因而不屬于“傳媒”之列,可平臺算法和用戶合作分發內容的機制在傳統的媒體機構里也屢見不鮮,而臉書等也仍舊雇傭大批人類合同工來定期清理其社交平臺的違禁信息。

當然,更重要的是,內容分發平臺(如谷歌、臉書)的收入絕大部分來自于廣告 —— 而這是傳媒機構一個標志性的特色。

十年前,臉書大佬扎克伯格面對已然過氣的傳統媒體不屑一顧, 一派硅谷新貴教育前浪們的自信滿滿:“對用戶來說,一只死在前院的松鼠也許比此刻非洲的戰火連天更為重要” (A squirrel dying in front of your house may be more relevant to your interests right now than people dying in Africa)。

十年后,面對干預大選、傳播虛假信息,分裂社會的指控,扎克伯格在國會面前吞吞吐吐。“我們對用戶在臉書上分享的內容負有責任嗎?”此刻的他也不得不承認:“我相信這個問題的答案是:是的。”。

另一位推特大佬杰克?多爾西(Jack Dorsey)則與時俱進。2020年,推特全面修改內容管理條例,最顯眼的轉變是它在特朗普幾乎每一句質疑選票的推特下都打上“此條可能與正式消息不符”的鋼印。

另一邊,面對內涵段子引發的爭議,張一鳴也不得不重新修改自己對算法的定義 —— “產品走錯了路,出現了與社會主義核心價值觀不符的內容,沒有貫徹好輿論導向,接受處罰,所有責任在我” 。

也許正如上個世紀初的西方新聞業一樣,新的監管準則和道德需求會圍繞內容推薦算法持續發酵;新的社會契約也會再次形成。扎克伯格和張一鳴們,相應地,也必須在承擔“算法責任”的基礎上做出調整。

至此,太平洋兩岸,一個算法客觀的時代過去了。

-------

參考文獻:

【1】Pariser, Eli. (2011). The filter bubble: How the new personalized web is changing what we read and how we think. Penguin, 2011.

【2】《對話張一鳴:世界不是只有你和你的對手》,財經,2016年12月14日

【3】Latour, B. (1994). On Technical Mediation. Common Knowledge. Fall Vol.3, no 2. pp. 32-33.

【4】Gillespie, T. (2014). The relevance of algorithms. Media technologies: Essays on communication, materiality, and society, 167(2014), 167.

【5】Napoli, P., & Caplan, R. (2017). Why media companies insist they're not media companies, why they're wrong, and why it matters. First Monday.

【6】Transcript of Zuckerberg’s appearance before the House committee. https://www.washingtonpost.com/news/the-switch/wp/2018/04/11/transcript-of-zuckerbergs-appearance-before-house-committee/

【7】張一鳴發公開信致歉:永久關停內涵段子,產品走錯了路。 https://tech.sina.com.cn/i/2018-04-11/doc-ifyuwqez8677545.shtml

-----

作者沈虹,畢業于美國伊利諾伊大學香檳分校傳播學系,現任職于美國卡內基梅隆大學。她用社會學的方法研究新興科技。

- 報料熱線: 021-962866

- 報料郵箱: news@thepaper.cn

互聯網新聞信息服務許可證:31120170006

增值電信業務經營許可證:滬B2-2017116

? 2014-2024 上海東方報業有限公司